La miniaturisation infinie n’existe pas, ou pourquoi l’informatique atteindra bientôt ses limites.

Aujourd’hui plutôt qu’un des habituels tutoriels et autres articles d’actualités habituellement publiés ici, je vous propose plutôt une réflexion, une analyse sur le sujet suivant : La loi de Moore est mourante, le progrès de la puissance informatique touche à sa fin et le Raspberry Pi Zero 2 W en est une illustration.

Cet article est donc davantage un article de fond, une explication et une analyse des limites auxquelles semble devoir se confronter l’industrie électronique. Bien que ne nécessitant pas de connaissances techniques, scientifiques ou économiques, il demande néanmoins probablement un peu plus d’attention que les articles habituellement publiés ici.

Dans cet article, je commencerai donc par revenir sur le nouveau produit lancé par la fondation, le Raspberry Pi Zero 2 W et sur ses évolutions vis à vis du modèle précédent. Par la suite, je chercherai à dresser un modèle et à proposer un cadre de référence offrant des aspects similaires, afin de permettre d’analyser et de théoriser les difficultés, les raisons et les enjeux de ces améliorations. À partir de ce modèle et de ce cadre de référence, je m’attacherai à analyser les techniques mises en œuvre pour apporter ces améliorations, et ce que ces techniques nous disent de l’état d’avancement du Raspberry Pi. Enfin, je conclurai cet article en commençant par montrer comment les propos développés pour le cas particulier du Raspberry Pi peuvent être élargis au reste de l’industrie électronique, avant d’offrir des pistes de réflexions sur ce vers quoi semble tendre le futur de cette industrie, pour terminer en interrogeant les décisions que nous pourrions alors êtres amenés à prendre.

Mais avant de rentrer dans l’analyse et la théorie, et à des fins de contexte, revenons dans un premier temps sur le nouveau modèle de Raspberry Pi qui servira d’exemple concret tout au long de cet article.

Le Raspberry Pi Zero 2 W, qu’est-ce et qu’est-ce qui change ?

Le Raspberry Pi est un micro-ordinateur de la taille d’une carte bleu, qui est bien connu des amateurs d’informatique. Historiquement, la gamme « Zero » du Raspberry Pi correspond à des machines plus petites, consommant moins d’électricité, et vendues à un prix plus bas (5€ ou 10€) que les autres modèles de Raspberry Pi. Cette gamme est donc naturellement considérée comme étant destinée à l’informatique embarquée, à la domotique, à l’IoT et de façon plus générale aux applications nécessitant peu de puissance de calcul et une consommation électrique ainsi qu’un espace physique réduits.

Le 18 Octobre 2021, la fondation Raspberry Pi a annoncé le lancement d’un nouveau modèle, le Raspberry Pi Zero 2 W, une évolution du Raspberry Pi Zero W.

Nouveau modèle, nouveau processeur, même mémoire vive…

Avec ce nouveau modèle, la fondation affiche la volonté d’améliorer la puissance de sa gamme dédiée à l’embarquée, sans offrir de nouvelles fonctionnalités. Il s’agit donc de permettre à ses ordinateurs mono-carte d’entrée de gamme de gagner en puissance, sans pour autant modifier la cible technique et commerciale du produit.

Cette stratégie est classique et correspond globalement à l’évolution naturelle d’un produit issu de l’industrie informatique dont la forme est déjà ancrée et aboutie. On est donc dans le cadre d’une évolution, comme le passage des disques dur 512 Go à 1 To, par opposition à une révolution, comme le passage des disques dur à plateau aux disques SSD.

La principale nouveauté avec ce modèle est l’arrivée, à la place de l’ancien processeur monocœur à architecture ARM11, d’un processeur quad-core à architecture ARM53, basé sur l’architecture du Raspberry Pi 4 et le processeur du Raspberry Pi 3.

Si ce nouveau processeur quad-core devrait offrir des gains importants en matière de puissance de calcul et donc de performances (la fondation annonce une multiplication par 5 des performances pour les applications multi-thread), on ne pourra s’empêcher de remarquer que la mémoire vive, elle, n’a pas été revue à la hausse, ce qui est pourtant la norme avec ce type d’évolution.

Cette stagnation de la RAM n’a pas manqué d’interroger les consommateurs et les observateurs médiatiques mais, vous allez le voir, elle n’a rien d’un hasard et semble pointer une sorte d’impasse vers laquelle se dirige doucement la fondation Raspberry Pi, comme le reste de l’industrie.

Prix, Encombrement, Puissance, une question d’équilibre.

Avec un nouveau modèle clairement axé sur la puissance plutôt que sur les nouvelles fonctionnalités, beaucoup se demandent pourquoi la fondation a choisi de n’intégrer « que » 512 Mo de RAM sur le Pi Zero 2 W. En fait, il y a fort à parier que la fondation n’a pas tellement eu le choix…

D’après l’article de blog accompagnant la sortie de ce nouveau modèle, augmenter la puissance du Pi Zéro semble en effet avoir été des plus compliqués. En cause ? Une sorte d’équivalent électronique de la crise du logement de nos grandes villes : plus il y a de monde, moins il y a de place et moins il y a de place, plus c’est cher…

Un concept qui peut également être retrouvé en partie au sein du livre « Snow Crash », en français « Le samouraï virtuel », à l’origine de la notion de métavers dont on entend beaucoup parler en ce moment.

Petite modélisation simplifiée de la théorie de l’encombrement à l’usage de l’industrie électronique.

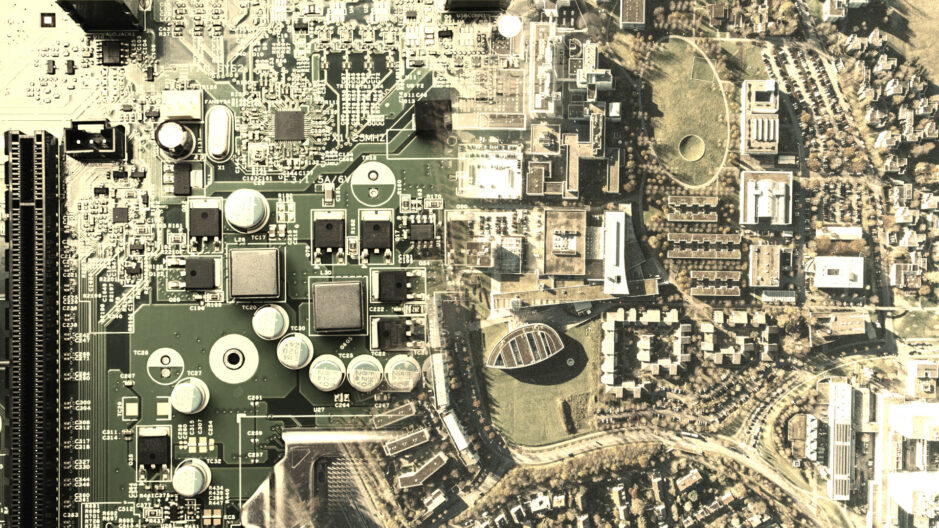

Un ordinateur mono-carte comme le Raspberry Pi, c’est plein de composants électroniques, reliés entre eux sur un seul circuit imprimé.

Si nous faisons abstraction des principes de fonctionnement interne, nous pouvons considérer qu’un composant offre un service dans une certaine quantité (vitesse de calcul, capacité de stockage, type de connectique et vitesse de transfert). Appelons cela de la « Puissance ».

Pour fournir cette puissance, le composant va imposer 3 contraintes, que l’on pourrait aussi modéliser comme l’utilisation d’un stock de ressources : il consomme de l’énergie ; il prend de la place ; il doit être relié aux autres composants. Appelons l’ensemble de ces contraintes « Encombrement », une notion qui peut être à rapprocher de celle abordée au sein de la théorie de l’encombrement.

Dans les faits de nombreuses autres contraintes peuvent être associées aux composants, comme des plages de tensions électriques, une sensibilité électromagnétique, une plage de températures d’utilisation, une vitesse de fonctionnement, une émission de chaleur, etc. Mais pour faire un modèle, c’est-à-dire une représentation approximative mais suffisamment bonne de la réalité pour nous permettre de la manipuler et de l’analyser dans un cadre donné, nous pouvons nous limiter à ces 3 contraintes. Les autres contraintes pouvant souvent être représentées par ces 3 contraintes de base, comme l’émission de chaleur qui se traduit classiquement sous forme de contraintes de consommation d’énergie et de place.

Enfin, un composant va avoir un coût monétaire, un prix, que nous appellerons donc avec beaucoup d’imagination« Prix ».

Je pense que vous l’aurez vu venir, il y existe un rapport direct entre Puissance, Encombrement et Prix. Pour simplifier, on pourrait modéliser ce rapport sous la forme Prix = Puissance / Encombrement. Ou pour l’exprimer d’une façon plus compréhensible encore : plus la puissance augmente pour le même encombrement, plus c’est cher.

À puissance égale, en payant un composant plus cher, il est souvent possible de diminuer son encombrement, et à l’inverse, en utilisant un composant plus encombrant, il est possible de le payer moins cher.

Comme on sature une ville, on sature un ordinateur.

Si nous prenons une ville, chacun sait qu’elle ne peut étendre sa taille à l’infini, a minima parce que le territoire dont nous disposons n’est pas infini. Chacun sait aussi que plus une ville offre de potentiel économique, culturel, etc., plus elle est considérée comme attractive, et plus nombreux sont les gens à vouloir y vivre. Il en résulte habituellement qu’une fois la taille maximale de la ville atteinte, par l’effet de contraintes de nature géographiques, historiques, politiques ou tout simplement structurelles (réseaux de transports, temps de trajets, etc.), celle-ci se met à transformer et optimiser son habitat.

Concrètement, cela se traduit habituellement de la façon suivante, le nombre des logements augmente tandis que leurs surfaces individuelles diminuent, et que le prix pour une même surface grimpe. Ou, dit plus simplement, chacun sait qu’on loue ou que l’on achète à Paris un appartement de 9m2 le prix d’une maison de 150m2 dans la Creuse.

Mais chacun sait aussi que cette optimisation atteint naturellement une limite, laquelle est habituellement imposée par l’espace minimal nécessaire à un habitat ― que cet espace soit fixé par la loi ou simplement dérivé de contraintes physiques et d’habitabilité ―, par l’exclusion de la partie de la population constituée des classes sociales ne pouvant plus payer le prix des logements, par la saturation des réseaux de transports, ou plus généralement par un mélange des trois, la ville étant alors qualifiée en français de « Capitale ».

C’est que, de même qu’il n’existe pas de croissance infinie, il n’existe pas non plus de diminution infinie, et comme il en va des villes, il en va des ordinateurs.

Un ordinateur mono-carte n’est pas si différent d’une ville. Lui aussi ne peut pas s’étendre à l’infini, étant limité par les dimensions du circuit imprimé porteur. Lui aussi dispose d’un équivalent aux logements, commerces et habitants, les composants électroniques, qui, comme leurs équivalents urbains, consomment tous un peu d’encombrement. Lui aussi doit avoir un réseau de transport, les pistes de cuivre. Et l’on pourrait encore trouver d’autres comparaisons, comme le traitement des eaux usées d’une ville, qui semble trouver un reflet dans la question de la dissipation thermique des composants électroniques.

Vous vous en doutez, le chemin suivi par un ordinateur ressemble, lui aussi, à celui d’une ville : l’optimisation de l’habitat. De même que se réduit la taille des appartements, se réduit la taille des composants. Et comme augmente le prix au mètre carré des appartements à mesure que leur surface diminue, augmente le prix des composants à puissance égale, à mesure que l’encombrement diminue.

Là aussi existe, comme pour celle des habitats, une limite à l’optimisation des composants. De même qu’un habitant ne peut pas vivre dans un appartement plus petit que lui, certains composants nécessitent un espace minimal (par exemple pour dissiper la chaleur émise). D’une façon similaire à celle par laquelle les réseaux de transports finissent par être saturés, on en arrive à ne plus avoir la place de relier des composants. Et comme l’augmentation des prix finit par rendre l’habitation inaccessible au plus grand nombre, l’augmentation des coûts des composants les plus performants empêche leur utilisation standard.

Et le Raspberry Pi dans tout ça ?

Vous l’aurez compris, toute la difficulté pour la fondation Raspberry Pi est donc de trouver l’équilibre entre l’encombrement du Raspberry Pi Zero 2 W (sa taille, sa consommation électrique, etc.), sont prix et sa puissance.

Aujourd’hui cet équilibre est à sa limite, et la fondation ne peut pas ajouter plus de RAM, principalement parce que la réserve d’encombrement disponible sur un Pi Zero, et notamment sa composante d’espace physique, est déjà presque totalement épuisée.

Le stock d’encombrement du Raspberry Pi Zero est fixe, il ne peut pas changer. Les dimensions de la carte doivent rester les mêmes, le nombre de couches de cuivre est limité pour des raisons économiques, la consommation électrique ne peut pas, ou à peine, augmenter.

Pour augmenter la puissance, la seule solution semble alors être une augmentation du prix. C’est d’ailleurs en partie ce que la fondation a fait, puisque ce nouveau modèle coûte 5€ de plus que le précédent, soit une augmentation de tout de même 50 %…

Mais là encore, l’augmentation du prix n’est pas une solution magique. D’abord parce qu’il faut que le produit reste achetable par une masse suffisante d’utilisateurs. Ensuite parce que, l’augmentation du prix est une conséquence, et non une cause, de la diminution de l’encombrement, laquelle, nous l’avons vu, ne saurait être illimitée.

La solution à cette crise du logement électronique ? Une sortie par le haut, pour le moment…

La situation de saturation que nous avons décrite n’est pas une nouveauté apparue avec la Raspberry Pi Zero 2 W, mais elle existait déjà depuis le premier modèle du Raspberry Pi Zero. Mais alors, avec un encombrement saturé et un prix encadré, comment la fondation a-t-elle pu augmenter la puissance du Pi Zero ?

En matière technologique, quand ce qui était impossible devient possible, une fois le mensonge éhonté mis de coté, il ne reste que l’innovation technologique. Reprenons notre comparaison immobilière.

Tout un chacun l’aura observé, quand une ville ne peut plus optimiser la taille de ses logements, et que s’étendre sur le territoire devient impossible, celle-ci se met alors à découvrir la troisième dimension et commence à se développer verticalement.

Ce développement à la verticale peut se faire dans deux sens, soit en creusant, soit en construisant des bâtiments plus hauts.

Même si des villes souterraines existent, et que les souplex semblent fleurir partout où cela est possible, creuser reste une solution rarement retenue pour la constructions de bâtiments, et est plutôt utilisée pour les réseaux de transports. Une situation, nous le verrons, là encore assez similaire avec celle des circuits imprimés.

Augmenter la hauteur des bâtiments reste donc la solution privilégiée la très vaste majorité du temps. Cette solution relève du point de vue architecturale d’une innovation technique, et elle connaît bien évidemment des limites, qu’il s’agisse de limites techniques, physiques, logistiques ou tout simplement de coûts. Et comme toute innovation technique, elle devient plus accessible techniquement et économiquement avec le temps, ce qui participe à augmenter son utilisation et sa rentabilité.

Si nous revenons au secteur informatique, la solution retenue par la fondation, et par l’industrie en général, est sans surprise la même, investir la verticale, et là aussi deux solutions sont possibles, creuser ou empiler.

Exploiter l’espace souterrain des circuits imprimés.

Dans le cadre de l’informatique, bâtir en sous-terrain prend deux formes bien distinctes. Puisque les circuits imprimés sont classiquement des plaques d’environ un millimètre d’épaisseur, constituées habituellement de résine époxy isolante et d’une ou plusieurs couches de cuivre conducteur, ces plaques sont susceptibles de présenter deux faces accessibles pouvant recevoir des composants électroniques, la face supérieure et la face inférieure.

Creuser peut alors, en premier lieu, être le fait d’utiliser la face inférieure du circuit en plus de la face supérieure pour souder des composants. On parle alors de circuit « double-sided » ou double-face en français. C’est une solution qui augmente sensiblement l’espace disponible, en allant au maximum jusqu’à le doubler, mais qui ne permet en revanche pas, ou pas totalement, de répondre à d’autres aspect de l’encombrement, comme la consommation électrique. Bien-sûr, réaliser un circuit double face implique des opérations d’assemblage plus complexes que d’utiliser un simple face, ce qui augmente mécaniquement le coût du circuit.

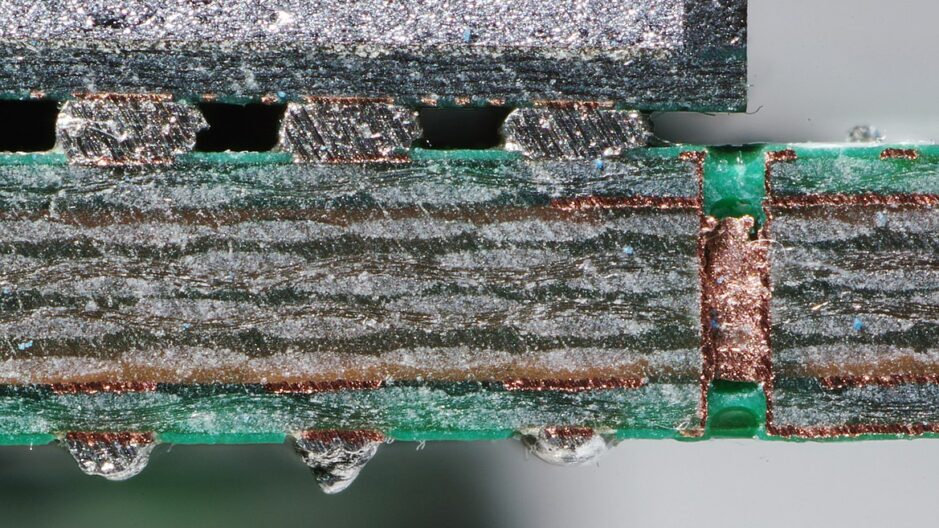

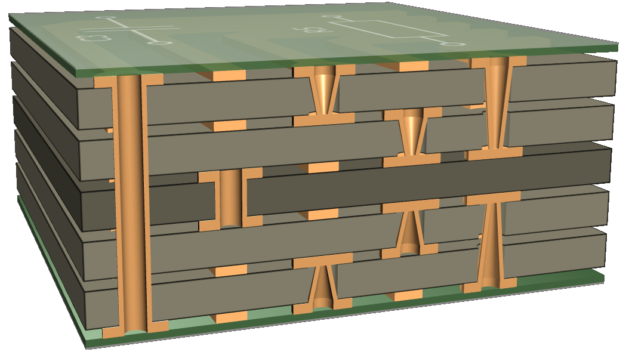

Mais creuser peut aussi s’apparenter, comme pour une ville, à répartir le réseau de transport, ici les pistes de cuivre sur plusieurs niveaux. C’est là la principale utilisation du développement « sous-terrain » des circuits imprimés. Pour cela, plusieurs couches de cuivre sont empilées et séparées par des couches d’isolant, puis reliées entre elles aux endroits nécessaires par la réalisation de trous, nommés « vias », qui seront ensuite rendus conducteurs par le dépôt d’une couche de cuivre.

C’est que le problème du branchement des composants entre eux se heurte à deux principales difficultés, la résistance électrique des pistes de cuivre et leurs croisements.

Le problème de la résistance, c’est que le cuivre n’est pas un conducteur parfait, et l’électricité en passant fait chauffer le cuivre. Pour diminuer cet effet, il est nécessaire de raccourcir les pistes, et d’augmenter leur largeur. Mais plus le nombre de composants est grand, plus il devient difficile de trouver des pistes courtes pour les relier, et plus les pistes sont larges, moins on peut en mettre dans un espace donné. En augmentant le nombre de couches, on simplifie leur tracé et on augmente la surface totale de cuivre disponible.

Le problème des croisements, c’est qu’il n’est pas possible sur une seule couche de cuivre en deux dimensions de faire se croiser des routes, celles-ci étant conductrices. Il devient alors nécessaire d’introduire une troisième dimension par l’ajout d’une ou plusieurs couches de cuivre. Plus il y aura de couches de cuivre, plus il sera simple de faire se chevaucher des routes, notamment en dédiant certaines couches à un type particulier de signal électrique. Évidemment, plus les couches sont nombreuses, plus le circuit est complexe à produire et donc cher.

Les produits issus de la haute industrie peuvent même, dans des cas extrêmes, recourir à une centaine de couches.

Aujourd’hui, la famille des Raspberry Pi Zero exploite déjà largement la répartition verticale du routage, avec un PCB qui semble contenir 6 couches de cuivre.

En revanche, les Raspberry Pi Zero n’utilisent qu’une seule face du circuit imprimé pour monter des composants. De cette façon, la chaîne de production est simplifiée, presque entièrement automatisée et ne nécessite pas l’étape plus complexe de retournement du circuit. C’est pour cette raison que les pins GPIO du Raspberry Pi ne sont pas livrés soudés.

Une solution pour permettre l’ajout de plus de RAM serait donc d’ajouter ou de déplacer des composants existants sur la face inférieure du Raspberry Pi Zero, pour libérer l’espace nécessaire à une puce de RAM supplémentaire. Cependant une telle modification impliquerait un changement du form-factor du Raspberry Pi Zero, susceptible d’introduire des incompatibilités avec certains matériels physiques, ainsi qu’une augmentation du coût de production.

Pour l’instant la fondation semble donc avoir rejeté l’idée de modifier le form-factor du Pi Zero et de passer à un format double-sided. À l’avenir ― et sauf évolution technologique majeure ou diminution drastique du coût de la RAM sur certaines solutions technologiques actuelles ― cette solution risque pourtant de s’avérer la seule possible si la fondation veut augmenter la mémoire vive de sa machine.

Construire des gratte-ciels de composants électroniques.

Puisqu’il n’est pas possible d’augmenter la capacité d’encombrement par le dessous, il ne reste alors qu’une solution à la fondation, gagner de la place par le haut en empilant les étages de composants.

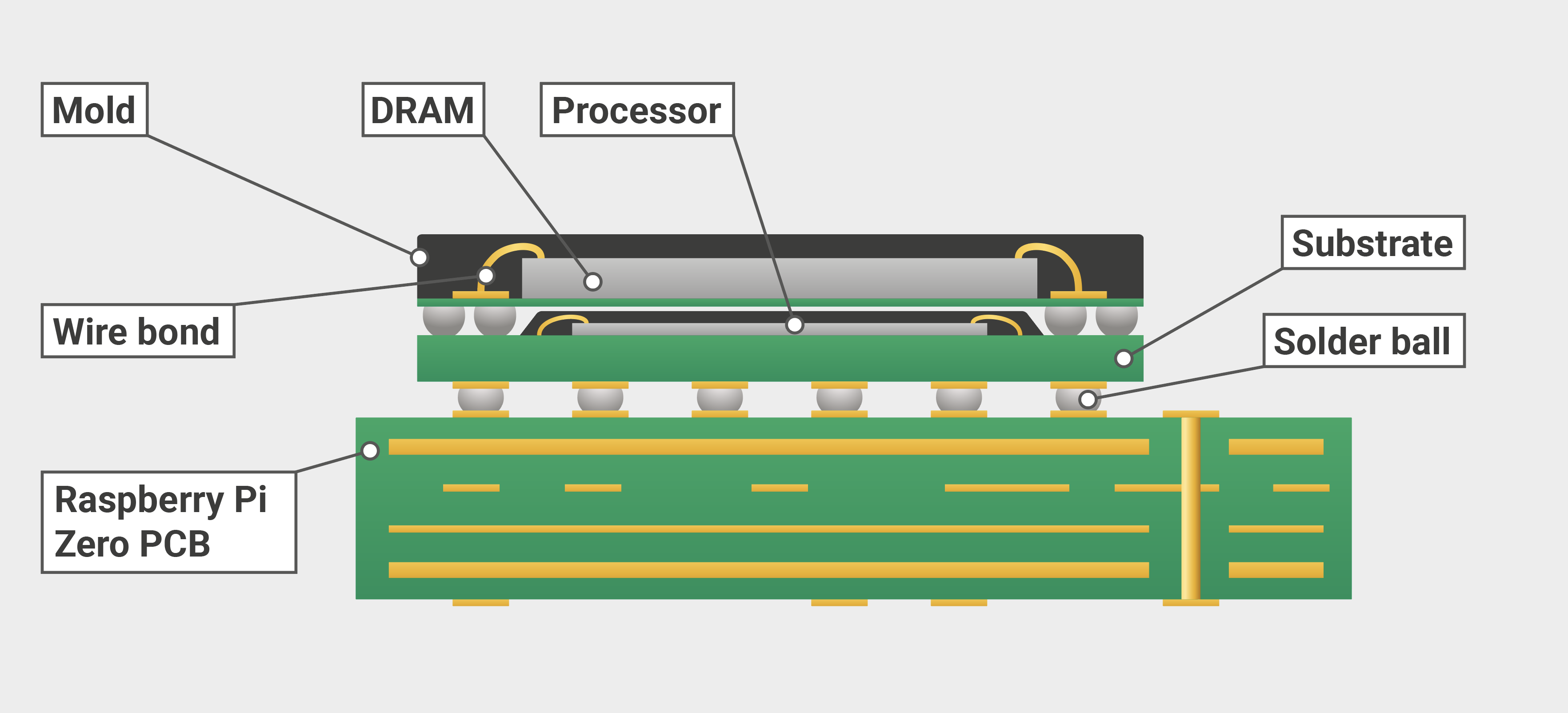

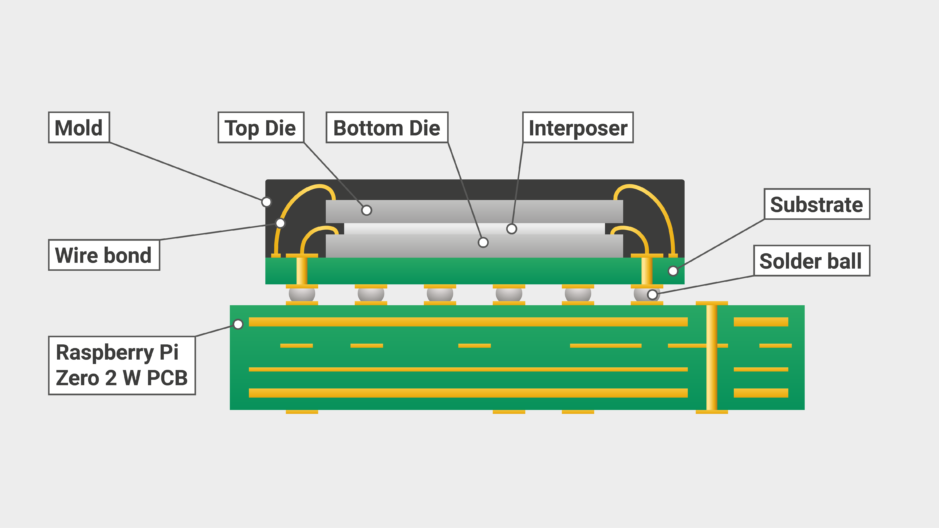

Figurez-vous que c’est déjà ce que font les versions précédentes de la Raspberry Pi Zero et de la Raspberry Pi 1, en utilisant une technologie appelée Package On Package, ou PoP. Comme son nom l’indique, cette technologie consiste à empiler un composant (package désigne le composant, soit l’ensemble de la puce de silicium et du boîtier permettant son isolation et sa connexion), sur un autre composant. C’est une technologie relativement récente, puisqu’elle n’est utilisée dans un produit industriel que depuis 2004 avec la PSP de Sony (devinez dans l’usine de qui sont produites les Raspberry Pi), et qui n’a vraiment connu une utilisation massive qu’avec l’avènement des smartphones, nécessitant une mémoire vive importante dans un volume réduit.

Jusqu’à présent, c’est grâce à la technologie PoP que la fondation pouvait intégrer la puce de mémoire vive au dessus de son processeur dans les Raspberry Pi Zero, permettant ainsi de créer la carte avec les dimensions que nous lui connaissons.

Cependant, comme vous pouvez le constater sur le schéma ci-dessus, l’utilisation de la technologie PoP implique que le composant inférieur soit suffisamment fin et petit pour pouvoir être placé entre les billes de soudure reliant le composant supérieur et le PCB servant de support. Et il se trouve que la fondation n’est pas la seule qui cherche à améliorer le rapport puissance / encombrement en passant à la verticale. Broadcom, le fabricant des System On Chip fournissant notamment le processeur de la Raspberry Pi fait de même, et avec son nouveau processeur, le System On Chip du Raspberry Pi Zero 2 W n’est plus suffisamment fin pour permettre le PoP.

Pour permettre le passage au nouveau processeur tout en conservant la même mémoire vive, la fondation a donc dû utiliser un autre procédé, le System In Package, ou SiP, qui consiste à superposer deux puces de silicium au sein d’un même boîtier, il s’agit là encore d’une technique assez récente et qui ne semble réellement utilisée par l’industrie que depuis quelques années.

Cependant, comme PoP, la technologie SiP a elle aussi ses limites, la plus importante étant la nécessiter de créer une puce dédiée.

En effet, là ou la technologie PoP exploite des composants pré-existants en les empilant sur un substrat qui n’est jamais qu’un mini-PCB très fin, rendant cette solution relativement accessible. La technologie SiP, elle, nécessite la création d’un nouveau composant dédié et fabriqué sur mesure, une opération beaucoup plus complexe, réalisable uniquement par quelques entreprises de pointe. Cette technologie est donc plus coûteuse, moins souple, implique un prototypage nettement plus compliqué et est, par nature, réservée à des entreprises disposant de volumes de commande importants et de liens privilégiés avec des entreprises majeures des semi-conducteurs, comme c’est évidemment le cas de la fondation avec son partenaire Broadcom…

Mais même si la technologie SiP a pu repousser certaines limites, là encore il n’existe pas de croissance infinie. Comme il n’est pas possible de faire des immeubles de 2 000 étages, il n’est pas possible d’empiler une infinité de puces de silicium. Sans même parler de l’épaisseur qu’auraient les composants, l’occupation d’espace physique n’est qu’une des composantes de l’encombrement, la quantité d’électricité consommée, l’émission de chaleur, le nombre de connexions sont autant de limites qui finissent toutes, tôt ou tard, par devenir insurmontables que ce soit pour des raisons de coûts ou des raisons physiques.

La fondation l’a d’ores et déjà dit, actuellement un modèle du Raspberry Pi Zero qui respecte le même form-factor et qui embarque plus de mémoire RAM semble exclu. Les puces de silicium nues de plus de 512 Mo de RAM n’existent pas, et empiler davantage de puces est aujourd’hui technologiquement trop compliqué et coûteux.

La dissipation thermique est également un problème. La fondation a pu, par l’ajout de pistes de cuivre, améliorer la dissipation thermique afin de permettre d’évacuer la chaleur supplémentaire générée par le nouveau processeur, mais là encore, cette solution touche à ses limites.

Le Raspberry Pi Zero 2 W dans sa forme actuelle semble arriver aux limites de la puissance atteignable à ce prix et dans cette forme.

Pour augmenter sa puissance il faudra donc augmenter son prix ou son encombrement (consommer plus d’électricité, augmenter la taille du produit, etc.). Ou bien aller chercher les améliorations et la plus-value ailleurs, dans la réduction de la consommation électrique, dans la spécialisation via le retrait de fonctionnalités au profit d’autres, etc.

Ce qu’il est important de comprendre, c’est que le Raspberry Pi Zero, loin d’être une exception, un cas particulier, est en fait l’illustration de la situation dans laquelle se trouve l’industrie de l’électronique des semi-conducteurs toute entière.

La croissance infinie n’existant pas, bientôt la loi de Moore prendra fin.

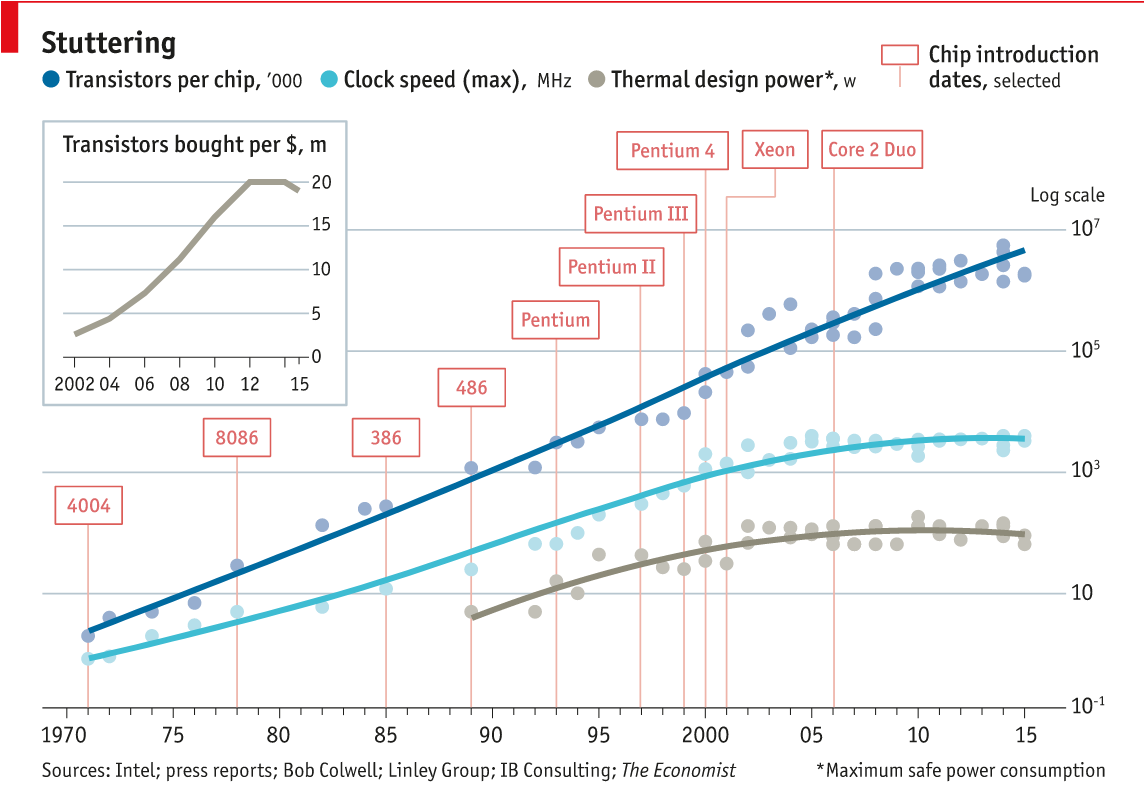

Toute personne s’étant intéressé à l’informatique connaît normalement la « loi de Moore », loi empirique formulée en 1965 par Gordon Earle Moore (lequel devait devenir 3 ans plus tard co-fondateur d’Intel), et qui voudrait que la puissance des processeurs double tous les ans ou tous les deux ans à coût comparable.

Si cette loi s’est jusqu’à aujourd’hui montrée assez juste, c’est en partie parce que l’industrie s’y est accrochée avec une ténacité forçant l’admiration, n’hésitant pas à consentir d’énormes investissements dans la recherche pour maintenir le rythme, effort économique qui n’a pu être consenti que parce que supporté financièrement par l’augmentation constante et effrénée de l’informatisation de nos sociétés. Et en partie parce que l’industrie et la presse ont souvent, par idéologie, intérêt ou simple méconnaissance, pris soin d’oublier la notion de « coût comparable ».

Pourtant et depuis quelques années déjà, un ralentissement se fait sentir, et le discours des constructeurs change, s’orientant moins sur la puissance et davantage vers une diminution de la consommation électrique, l’amélioration des performances par la spécialisation des circuits imprimés pour des tâches précises (intelligence artificielle, traitements graphiques, etc.), ou vers des bonds technologiques, comme l’informatique quantique.

Si la courbe du nombre de transistors par puce continue de suivre la loi de Moore jusqu’en 2015 (tendance qui tend désormais à disparaître), on observe en revanche clairement que les gains de performance thermique et de vitesse d’horloge diminuent depuis 2005 en allant vers une stagnation aux alentours de 2015. Simultanément le nombre de transistors par dollar suit une courbe plus lente avant de totalement stagner voir de régresser à partir de 2012.

Il semblerait que nous nous approchions chaque jour un peu plus des limites physiques de cette croissance, et que sa fin soit imminente. Depuis 2010 le progrès des micro-processeurs semble ralentir à l’échelle de toute l’industrie, les fréquences des processeurs semblent bloquées depuis 2015 par l’apparition d’effets quantiques, la finesse de gravure se dirige dans la même direction, et la « International Technology Roadmap for Semiconductors », qui avait jusque là guidé l’industrie en se basant très largement sur la loi de Moore a émis sa dernière feuille de route en 2016, appelant à s’en détacher.

Nous ne respections déjà plus la loi de Moore en en ignorant la notion de coût, bientôt nous ne la respecterons plus tout court. En fait, d’après de nombreux prévisionnistes, dont Moore lui même, la « loi de Moore » devrait prendre fin aux alentours de 2025.

Sans surprise, comme nos villes ont, en dernier recours, extrait à la verticale les derniers mètres carrés utilisables. De même les constructeurs de semi-conducteurs ne pouvant plus miniaturiser, arrachent-ils désormais, et déjà depuis quelques temps, les dernières améliorations de performances par la création de puces de silicium en trois dimensions. Hélas, une fois la verticale totalement conquise, il n’y aura plus d’autres dimensions physiques accessibles…

Nos villes semblent désormais êtres saturées et ne pas pouvoir accueillir plus de population, amenant nos sociétés à remettre en cause un modèle d’ultra-urbanisation qui les a longtemps guidées et à repenser notre rapport au territoire, au travail, au transport.

En cela, comme en tout le reste, il me semble y avoir fort à parier que l’industrie des semi-conducteurs et à travers elle toute l’industrie informatique, suive le modèle de nos villes. Bientôt, nous aurons tiré toute la puissance brute que nous pouvions espérer extraire d’un morceau de silicium. Pour la première fois depuis 1965, l’évolution des vitesses de calcul ne sera plus dépendante d’une évolution si ce n’est prédictible, au moins estimable, mais d’une révolution technologique qui pourrait ne jamais venir.

Il va alors nous falloir repenser notre rapport à la puissance de calcul et à son optimisation, comme nous repensons notre rapport au territoire et à la centralisation. Nous allons devoir optimiser d’autres aspects de l’encombrement trop longtemps négligés, comme la consommation électrique, la dissipation voir la réutilisation de la chaleur. Nous devrons optimiser la fabrication pour diminuer les coûts et la consommation de ressources afin de réduire les prix.

Ou alors, simplement, nous satisfaire de notre puissance de calcul disponible, après tout, peut-être déjà suffisante. Accepter que nous n’avons pas nécessairement besoin de calculer plus, de partager plus, de surveiller plus, de prédire toujours et toujours plus, toujours plus vite. Accepter que toute limite n’appelle pas, forcément, à être dépassée. Que parfois, s’arrêter est non seulement nécessaire, mais souhaitable, profitable, raisonnable.

Il n’y a pas de miniaturisation infinie, pas plus qu’il n’y a de croissance infinie. En un monde fini, seuls les fous et les économistes peuvent croire en de telles choses.

Lire l'article complet : La miniaturisation infinie n’existe pas, ou pourquoi l’informatique atteindra bientôt ses limites.